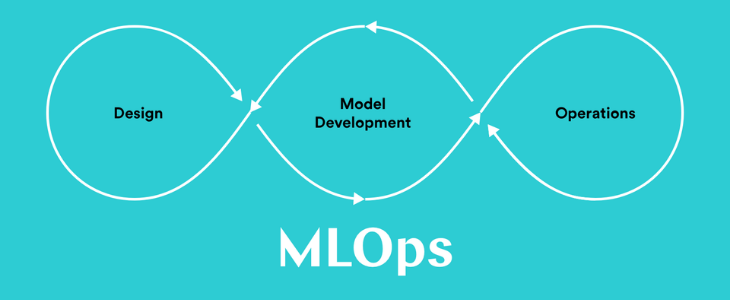

5 best practices voor het operationaliseren van Data Science (MLOps)

Steeds meer bedrijven passen Data Science of Machine Learning (ML) toe om voorspellingen en verwachtingen te kunnen maken op basis van hun data. Dit doen ze om sneller te kunnen reageren op mogelijke veranderingen die van invloed zijn op hun bedrijfsprocessen, hun onderscheidend vermogen in de markt of het automatiseren van beslissingen. Enkele (bekende) voorbeelden zijn:

- Predictive Maintenance, risico-gebaseerd onderhoud uitvoert op assets met een bepaalde verwachtte faalkans,

- Klant aanbevelingen, het cross- en/of upsellen op basis van personen met gelijke interesses/aankopen

- Fraude detectie

Veel organisaties hebben de afgelopen jaren geïnvesteerd om kennis en expertise op te bouwen op het gebied van data analyse en Data Science. Vaak is dit versnipperd binnen de organisatie. Als er successen worden geboekt, dan blijkt het vaak dat het operationaliseren van de oplossing in het IT-landschap complex is, dit niet integreert en daardoor stagneert of het blijft bij Data Scientists die hun prototypes zelf in de lucht houden.

De laatste jaren zijn voor dit probleem heel veel (deel)oplossingen op de markt gekomen en hierdoor wordt het steeds lastiger door de bomen het bos te zien.

In dit blog bespreek ik de 5 best practices voor het succesvol operationaliseren van Data Science projecten, die ook wel onder de noemer van MLOp worden gevat.

1. Hybride expertise teams

Data Science is vaak gescheiden van de IT organisatie en de IT teams die een data platform bouwen en onderhouden. Vaak wordt een voorspellende model "over de schutting geworpen" richting IT als het geoperationaliseerd moet worden. Als de afstand tussen de Data Scientist en de ML of Data engineers te groot is, leidt dit tot onbegrip, lange trajecten, veel herbouw. Hybride DevOps teams, waarin de verschillende expertises dichtbij elkaar zitten en aan dezelfde analytics producten werken, zorgen ervoor dat men vanuit innovatie snel tot operationalisatie komt.

2. Business integratie en feedback

De waarde van de voorspellende modellen is om betere, geautomatiseerdere beslissingen te kunnen nemen. De business die met deze modellen werkt, moet kunnen en durven vertrouwen op de uitkomsten. Meestal is er weerstand of onbegrip die het vertrouwen ondermijnen. Neem daarom de eindgebruikers vroegtijdig mee in de ontwikkeling van die modellen, en laat ze met de resultaten werken, bijvoorbeeld in de schaduw van hun huidig proces. Hiermee krijgen ze voldoende tijd voor adoptie.

Neem ook hun feedback mee met betrekking tot de bruikbaarheid van de resultaten om hiermee de kwaliteit van het model te verbeteren. Het ultieme doel is om een continue feedback mechanisme te integreren, zodat de modellen door gebruik in de tijd beter en accurater gemaakt kunnen worden.

3. Monitoring

De accuraatheid van een model valt of staat met de kwaliteit van de data. In een productie situatie kan er van alles voorbij komen (geen data, ontbrekende data , foute data, etc). Bij het operationalieseren moet het model dusdanig robuust worden gemaakt dat het hiermee om kan gaan.

Als gebruiker wil je ook inzicht hierin hebben. Daarom is integrale monitoring van essentieel belang. Enkele aspecten :

- kwaliteit van de input data inclusief statistische meerwaarden

- statistische performance van het model; als de input teveel gaat afwijken van waarop het model is getraind, wordt de accuraatheid minder. Dit kan een aanwijzing zijn om opnieuw te trainen met de nieuw vergaarde data

- Bias quantificeren ; elk model heeft een zekere bias. Door inzicht in de bias kun je model gebaseerde besluitvorming beter verantwoorden en bijvoorbeeld racistische uitkomsten detecteren.

4. Data platform

Het is niet noodzakelijk om eerst een dataplatform te realiseren, voordat je kunt operationaliseren. Als meer modellen worden geoperationaliseerd, is een dataplatform wel een essentieel onderdeel om te kunnen schalen. Tegenwoordig hebben de meeste organisaties al een dataplatform in een verschillende staat van volwassenheid. Het is belangrijk om de groeistrategie van het dataplatform af te stemmen op de Data Science innovaties die op de rol staan om geoperationaliseerd te worden.

Een hedendaags dataplatform gericht op het operationaliseren van Data Science bevat de volgende 5 kern-functionaliteiten:

- Data Ingestion & Processing

- Monitoring

- Model training en experimenten

- Model deployment en lifecycle management

- Feature store

De realisatie van een dataplatform kan door aanschaf van één integrale ‘gesloten' oplossing, het afnemen van cloudprovider services, of door verschillende open source componenten aan elkaar te koppelen. Voor de laatste optie steeds meer oplossingen beschikbaar die de best-of-breed open source technologieën combineren.

5. Automatiseren

Vanuit de DevOps principes overgenomen en ter bevordering van onderhoudbaarheid , reproductie, fout reductie en schaalbaarheid is het van belang zoveel mogelijk te automatiseren. Dit kan in een iteratief proces waarin steeds meer stappen uit de keten worden ge-automatiseerd. Hierdoor kan het model in een vroeg stadium al worden gebruikt en zijn waarde leveren, ondanks handmatige stappen, terwijl gaandeweg steeds meer wordt geautomatiseerd om de ‘OPS’ kwaliteit en performance te verbeteren. De tools uit de DevOps hoek zijn ook inzetbaar om Data Science workflows te automatiseren.

MLOps wint de laatste jaren steeds meer aan populariteit. In eerste helft van 2021 zijn al miljoenen geïnvesteerd in verschillende MLOps bedrijven.

Meer weten?

Wil je meer weten over de waarde die Data Science je bedrijf kan bieden? Download dan de ‘Handleiding voor succesvolle Data Science projecten”. Daarin vertellen we je wat de factoren van een geslaagd Data Science project zijn en in welke stappen je van een idee tot een goede oplossing komt.

Gerelateerde artikelen